NVIDIA startet DGX-Cloud und ermöglicht Unternehmen den sofortigen Zugriff auf KI-Supercomputer

Aufklärung über Eigenpositionen: Diese Aktien aus dem Artikel halten TraderFox-Redakteure aktuell

Was kann die DGX-Cloud?

Die DGX-Cloud bietet dedizierte Cluster von NVIDIA DGX AI Supercomputing, gepaart mit NVIDIA AI Software. Der Service ermöglicht es jedem Unternehmen, über einen einfachen Webbrowser auf seinen eigenen KI-Supercomputer zuzugreifen, wodurch die Komplexität der Anschaffung, Bereitstellung und Verwaltung von Infrastruktur vor Ort entfällt.

Unternehmen mieten DGX-Cloud-Cluster auf monatlicher Basis und können so die Entwicklung großer Trainingslasten mit mehreren Knoten schnell und einfach skalieren, ohne auf beschleunigte Rechenressourcen warten zu müssen, die oft sehr gefragt sind.

"Wir befinden uns in der iPhone-Phase der KI. Startups rennen um die Wette, um bahnbrechende Produkte und Geschäftsmodelle zu entwickeln, und die etablierten Unternehmen versuchen, darauf zu reagieren", sagt Jensen Huang, Gründer und CEO von NVIDIA. "DGX-Cloud gibt Kunden sofortigen Zugang zu NVIDIAs KI-Supercomputing in globalen Clouds."

Starke Partnerschaften untermauern das Projekt

NVIDIA geht Partnerschaften mit führenden Cloud-Service-Anbietern ein, um die DGX-Cloud-Infrastruktur zu hosten, angefangen mit Oracle Cloud Infrastructure (OCI). Der OCI-Supercluster bietet ein speziell entwickeltes RDMA-Netzwerk, Bare-Metal-Computing und hochleistungsfähige lokale Blockspeicher, die auf Supercluster mit über 32.000 GPUs skalieren können.

Es wird erwartet, dass Microsoft Azure im nächsten Quartal mit dem Hosting von der DGX-Cloud beginnen wird. Der Service wird bald auch auf Google Cloud und andere Anbieter ausgeweitet.

Branchenriesen setzen auf die DGX-Cloud, um ihren Erfolg zu beschleunigen

Zu den ersten KI-Pionieren, die DGX-Cloud nutzen, gehören Amgen, eines der weltweit führenden Biotechnologieunternehmen, der führende Versicherungstechnologieanbieter CCC Intelligent Solutions (CCC) und ServiceNow, der Anbieter von Plattformen für digitale Geschäfte.

Amgen nutzt die DGX-Cloud mit der NVIDIA BioNeMo™ Software für große Sprachmodelle, um die Medikamentenentwicklung zu beschleunigen, einschließlich der NVIDIA AI Enterprise Software, die NVIDIA RAPIDS™ Bibliotheken zur Beschleunigung der Datenwissenschaft enthält.

"Mit NVIDIA DGX-Cloud und NVIDIA BioNeMo können sich unsere Forscher auf die tiefere Biologie konzentrieren, anstatt sich mit der KI-Infrastruktur und der Einrichtung von ML-Engineering beschäftigen zu müssen", sagte Peter Grandsard, Executive Director of Research bei Amgen. "Die leistungsstarken Rechen- und Multi-Knoten-Fähigkeiten der DGX-Cloud haben es uns ermöglicht, im Vergleich zu alternativen Plattformen ein dreimal schnelleres Training von Protein-LLMs mit BioNeMo und eine bis zu 100-mal schnellere Analyse nach dem Training mit NVIDIA RAPIDS zu erreichen."

CCC, eine führende Cloud-Plattform für die Schaden- und Unfallversicherungswirtschaft, nutzt DGX-Cloud, um die Entwicklung und das Training seiner KI-Modelle zu beschleunigen und zu skalieren. Diese Modelle bilden die Grundlage für die innovativen Lösungen des Unternehmens zur Beilegung von Kfz-Schäden und tragen dazu bei, die intelligente Automatisierung der Branche zu beschleunigen und die Schadenerfahrung von Millionen von Geschäftskunden und deren Kunden täglich zu verbessern.

ServiceNow wiederum nutzt die DGX-Cloud zusammen mit lokalen NVIDIA DGX Supercomputern für flexibles, skalierbares Hybrid-Cloud-KI-Supercomputing, das die KI-Forschung in den Bereichen große Sprachmodelle, Codegenerierung und Kausalanalyse unterstützt. ServiceNow unterstützt auch das BigCode-Projekt, eine verantwortungsvolle Open-Science-Initiative für generative KI, die auf dem Megatron-LM-Framework von NVIDIA trainiert wird.

NVIDIA Base Command Platform

Unternehmen verwalten und überwachen DGX-Cloud-Trainings-Workloads mit der NVIDIA Base Command™ Platform Software, die eine nahtlose Benutzererfahrung über die DGX-Cloud sowie über lokale NVIDIA DGX Supercomputer bietet. Mit der Base Command Platform können Kunden ihre Workloads auf die richtige Menge und Art der DGX-Infrastruktur abstimmen, die für das jeweilige Projekt benötigt wird.

Die DGX-Cloud umfasst NVIDIA AI Enterprise, die Softwareschicht der NVIDIA AI-Plattform, die End-to-End-KI-Frameworks und vortrainierte Modelle bereitstellt, um Data-Science-Pipelines zu beschleunigen und die Entwicklung und Bereitstellung von Produktions-KI zu optimieren. Neue vortrainierte Modelle, optimierte Frameworks und beschleunigte Data-Science-Softwarebibliotheken, die in der gestern veröffentlichten Version 3.1 von NVIDIA AI Enterprise verfügbar sind, geben Entwicklern einen zusätzlichen Startvorteil für ihre KI-Projekte.

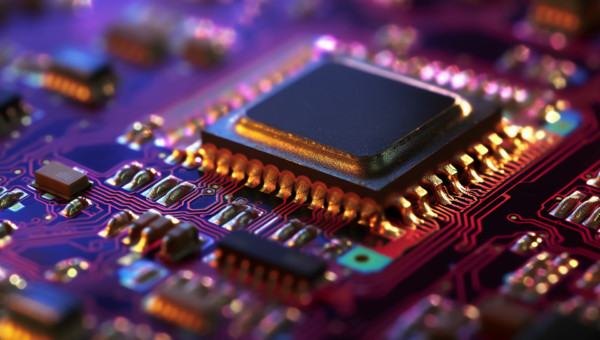

Technische Details

Jede Instanz von DGX-Cloud verfügt über acht NVIDIA H100 oder A100 80GB Tensor Core GPUs mit insgesamt 640GB GPU-Speicher pro Knoten. Eine hochleistungsfähige Infrastruktur mit geringer Latenz, die mit NVIDIA Networking aufgebaut wurde, stellt sicher, dass Arbeitslasten über Cluster von miteinander verbundenen Systemen hinweg skaliert werden können, so dass mehrere Instanzen wie ein einziger massiver Grafikprozessor agieren können, um die Leistungsanforderungen fortschrittlicher KI-Trainings zu erfüllen. Auch ein Hochleistungsspeicher ist in DGX-Cloud integriert, um eine Komplettlösung für KI-Supercomputing zu bieten.

Die DGX-Cloud bietet Unterstützung durch NVIDIA-Experten während der gesamten KI-Entwicklungspipeline. Kunden können direkt mit NVIDIA-Ingenieuren zusammenarbeiten, um ihre Modelle zu optimieren und Entwicklungsprobleme in einem breiten Spektrum von Anwendungsfällen schnell zu lösen.

DGX-Cloud-Instanzen sind ab 36.999 USD pro Instanz und Monat erhältlich. Unternehmen können sich für weitere Informationen an ihren NVIDIA Partner Network Vertreter wenden.

& Profi-Tools von

& Profi-Tools von