Google präsentiert Supercomputer mit höherer Geschwindigkeit und Energieeffizienz als Nvidia-Systeme

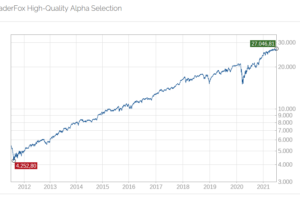

Aufklärung über Eigenpositionen: Diese Aktien aus dem Artikel halten TraderFox-Redakteure aktuell

Google veröffentlichte am Mittwoch, den 05.03. Details zu einem seiner Supercomputer für künstliche Intelligenz und erklärte, dass er schneller und effizienter als konkurrierende Nvidia-Systeme sei. Während Nvidia derzeit den Markt für das Training und die Bereitstellung von KI-Modellen mit einem Marktanteil von über 90 % dominiert, hat Google seit 2016 eigene KI-Chips namens TPUs entwickelt und im Einsatz.

Einige Experten kritisieren jedoch, dass Google in der Vermarktung seiner Innovationen hinterherhinkt. Um zu beweisen, dass das Unternehmen seine führende Position nicht eingebüßt hat, arbeiten die Mitarbeiter intern fieberhaft daran, neue Produkte auf den Markt zu bringen. Laut einem Bericht von CNBC hat Google intern eine "Code-Red-Situation" ausgerufen, um den Druck zu erhöhen.

TPUs sind schneller und effizienter als GPU A100 von Nvidia

Google gab bekannt, dass es ein System mit über 4.000 TPUs und speziell entwickelten Komponenten gebaut hat, das zur Schulung von KI-Modellen verwendet wurde. Es läuft seit 2020 und wurde zur Schulung von Googles PaLM-Modell eingesetzt, das mit OpenAI's GPT-Modell konkurriert.

Google's TPU-basierter Supercomputer namens TPU v4 ist laut den Google-Forschern "1,2x-1,7x schneller und verbraucht 1,3x-1,9x weniger Strom als der Nvidia A100". Die Leistung, Skalierbarkeit und Verfügbarkeit machen TPU v4-Supercomputer zu den Arbeitspferden großer Sprachmodelle, so die Forscher.

H100 von Nvidia liefert 4-fach höhere Leistung als A100

Jedoch wurden die Ergebnisse von Googles TPU nicht mit dem neuesten KI-Chip von Nvidia, dem H100, verglichen, da dieser Chip neuer und mit fortschrittlicherer Fertigungstechnologie hergestellt wurde, sagten die Google-Forscher.

Ergebnisse und Ranglisten eines branchenweiten KI-Chip-Tests namens MLperf wurden ebenfalls am Mittwoch veröffentlicht. Der CEO von Nvidia, Jensen Huang, kommentierte diese in einem Blogbeitrag: "Heute zeigt MLPerf 3.0, dass Hopper (H100) eine 4-fach höhere Leistung als A100 liefert".

& Profi-Tools von

& Profi-Tools von