Nvidia unter Druck: Warum die Zukunft der KI auf Spezialisierung statt Größe setzt

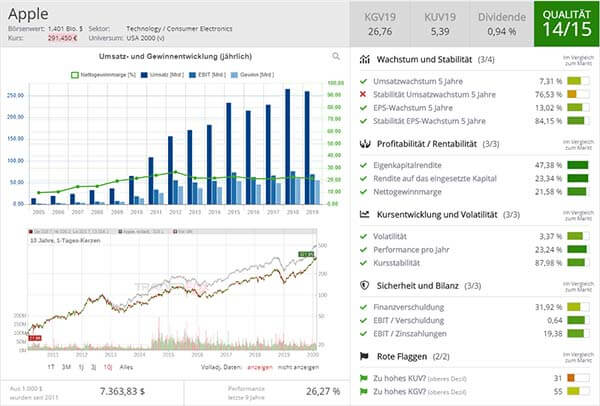

Aufklärung über Eigenpositionen: Diese Aktien aus dem Artikel halten TraderFox-Redakteure aktuell

Die Einführung von ChatGPT markierte den Beginn eines neuen Booms in der Künstlichen Intelligenz (KI). Die Branche folgte lange der Annahme, dass größere Modelle automatisch bessere Ergebnisse liefern. Diese Denkweise trieb Technologieriesen wie Microsoft, Google, Amazon und Meta in einen Milliardenwettlauf um leistungsfähige Chips, vor allem von Nvidia. Doch dieses Paradigma wird zunehmend hinterfragt, da die Branche auf technische und datenbezogene Grenzen stößt. Ein Paradigmenwechsel zeichnet sich ab.

Grenzen der Skalierung: "Minimaler Nutzen über eine Billion Parameter"

Die Idee, dass die Größe eines Modells dessen Leistung garantiert, verliert an Überzeugungskraft. "Es gibt nur minimale Verbesserungen oder Erträge über eine Billion Parameter hinaus", erklärt Waseem Alshikh, Mitgründer des KI-Start-ups Writer, im Gespräch mit Barron’s, einer führenden US-amerikanischen Wirtschaftszeitschrift. Neben den technischen Herausforderungen fehlt es zunehmend an qualitativ hochwertigen Trainingsdaten. "Wir haben das Internet als Datenquelle vor Monaten erschöpft", ergänzt Thomas Wolf, Mitgründer des KI-Marktplatzes Hugging Face. Damit wird es schwieriger, durch zusätzliche Parameter spürbare Fortschritte zu erzielen.

Von Training zu Inferenz: Eine neue Ära

Jahrelang stand das Training großer Modelle im Mittelpunkt der KI-Entwicklung. Nun rückt die Inferenz in den Fokus – der Prozess, bei dem trainierte Modelle Ergebnisse aus neuen Daten generieren. Microsoft-CEO Satya Nadella bezeichnet diesen Wechsel als "ein neues Skalierungsgesetz, basierend auf der Rechenleistung während der Inferenz".

Dieser Wandel hat weitreichende Konsequenzen: Die Inferenzphase stellt andere Anforderungen an Hardware als das Training. Das eröffnet Konkurrenten wie AMD, Intel, Amazon und innovativen Start-ups neue Chancen, den Markt zu betreten. AMDs Instinct MI300X beispielsweise liefert bei Inferenz-Workloads laut eigenen Angaben bis zu 1,6-mal mehr Leistung als Nvidias H100.

Nvidia: Führungsrolle unter Druck

Nvidia, bisher unangefochtener Marktführer im Bereich KI-Hardware, ist sich dieser Veränderungen bewusst. Bereits 40 % der Rechenzentrumsumsätze stammen aus der Inferenz, einem stark wachsenden Bereich. Das neue NVL72-Serversystem soll eine 30-fache Verbesserung der Inferenzleistung bringen und Nvidias Position sichern. Dennoch nimmt der Druck durch Konkurrenten zu.

"Was wir in dieser Ära der generativen KI gelernt haben, ist, dass nicht nur die Skalierung wichtig ist, sondern auch Fortschritte in Bereichen wie Gedächtnis, Planung und Reasoning", erklärt Yann LeCun, Chief AI Officer von Meta. Statt immer größere Modelle zu bauen, plädiert er für intelligenter designte Systeme, die langfristig den Weg zu Künstlicher Allgemeiner Intelligenz (AGI) ebnen könnten.

Neue Gewinner: Spezialisierung statt Masse

Die Entwicklungen deuten darauf hin, dass der Markt für KI zunehmend fragmentiert wird. Kleinere, spezialisierte Modelle, die auf spezifischen Daten trainiert und effizient eingesetzt werden können, könnten an Bedeutung gewinnen. "Es gibt keine Wand", betont OpenAI-CEO Sam Altman und signalisiert damit, dass Innovation nicht an der Größe eines Modells endet.

Fazit: Ein Wettlauf mit offenem Ausgang

Die Ära der unreflektierten Modellvergrößerung neigt sich dem Ende zu. Fortschritte in der Inferenztechnologie könnten Nvidia kurzfristig Vorteile bringen, eröffnen jedoch langfristig neue Chancen für Wettbewerber. Der KI-Markt steht vor einem Wandel: Spezialisierte Anwendungen und neue Technologien könnten die bisherigen Kräfteverhältnisse verschieben und den Weg für neue Gewinner ebnen. Die Zukunft der KI bleibt spannend – und ungewiss.

& Profi-Tools von

& Profi-Tools von