AWS und NVIDIA erweitern ihre Zusammenarbeit, um generative KI-Innovationen voranzutreiben

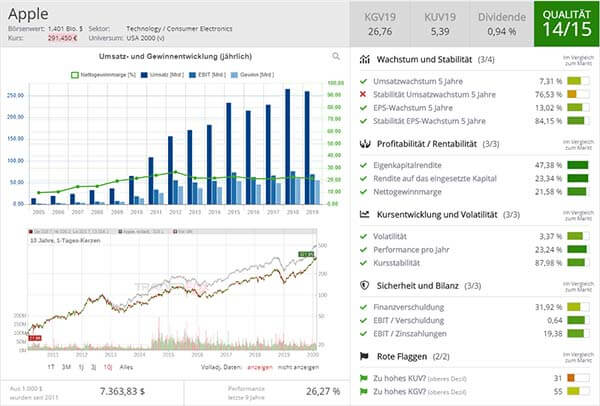

Aufklärung über Eigenpositionen: Diese Aktien aus dem Artikel halten TraderFox-Redakteure aktuell

AWS wird den NVIDIA GB200 Grace Blackwell Superchip und die B100 Tensor Core GPUs anbieten und damit die langjährige strategische Zusammenarbeit der beiden Unternehmen ausbauen, um die sicherste und fortschrittlichste Infrastruktur, Software und Services bereitzustellen, die Kunden helfen, neue generative KI zu erschließen. Gemeinsam stellen sie die Infrastruktur und Tools bereit, die es Kunden ermöglichen, Echtzeit-Inferenzen auf großen Sprachmodellen (LLMs) mit mehreren Billionen Parametern schneller, in großem Maßstab und zu niedrigeren Kosten als NVIDIA-GPUs der vorherigen Generation auf Amazon EC2 zu erstellen und auszuführen.

"Die enge Zusammenarbeit zwischen unseren beiden Unternehmen reicht mehr als 13 Jahre zurück, als wir gemeinsam die weltweit erste GPU-Cloud-Instanz auf AWS starteten, und heute bieten wir die größte Auswahl an NVIDIA-GPU-Lösungen für Kunden", sagte Adam Selipsky, CEO von AWS. "Der Grace-Blackwell-Prozessor der nächsten Generation von NVIDIA ist ein bedeutender Schritt in Richtung generativer KI und GPU-Computing. In Kombination mit dem leistungsstarken Elastic Fabric Adapter Networking von AWS, dem Hyper-Scale-Clustering von Amazon EC2 UltraClusters und den fortschrittlichen Virtualisierungs- und Sicherheitsfunktionen unseres einzigartigen Nitro-Systems ermöglichen wir es unseren Kunden, große Sprachmodelle mit mehreren Billionen Parametern schneller, in großem Maßstab und sicherer als irgendwo sonst zu erstellen und auszuführen. Gemeinsam arbeiten wir weiter an Innovationen, um AWS zum besten Ort für den Betrieb von NVIDIA-GPUs in der Cloud zu machen."

"KI treibt Durchbrüche in einem noch nie dagewesenen Tempo voran und führt zu neuen Anwendungen, Geschäftsmodellen und Innovationen in allen Branchen", sagt Jensen Huang, Gründer und CEO von NVIDIA. "Unsere Zusammenarbeit mit AWS beschleunigt neue generative KI-Funktionen und bietet Kunden eine noch nie dagewesene Rechenleistung, um die Grenzen des Möglichen zu erweitern."

Neueste Innovationen von AWS und NVIDIA beschleunigen die Schulung von hochmodernen LLMs

AWS wird die NVIDIA Blackwell-Plattform mit GB200 NVL72 anbieten, mit 72 Blackwell-GPUs und 36 Grace-CPUs, die durch NVIDIA NVLink™ der fünften Generation miteinander verbunden sind. In Verbindung mit Amazons leistungsfähigem Netzwerk (EFA) und unterstützt durch fortschrittliche Virtualisierung (AWS Nitro System) und Hyper-Scale Clustering (Amazon EC2 UltraClusters) können Kunden auf Tausende von GB200 Superchips skalieren. NVIDIA Blackwell auf AWS bietet einen enormen Fortschritt bei der Beschleunigung von Inferenzarbeitslasten für ressourcenintensive Sprachmodelle mit mehreren Billionen Parametern. Die von Blackwell betriebenen DGX Cloud-Instanzen auf AWS werden die Entwicklung modernster generativer KI und LLMs beschleunigen, die mehr als 1 Billion Parameter erreichen können.

Project Ceiba nutzt Blackwell, um NVIDIAs zukünftige generative KI-Innovation auf AWS voranzutreiben

Das auf der AWS re:Invent 2023 angekündigte Projekt Ceiba ist eine Zusammenarbeit zwischen NVIDIA und AWS, um einen der schnellsten KI-Supercomputer der Welt zu bauen. Der Supercomputer wird exklusiv auf AWS gehostet und steht für NVIDIAs eigene Forschung und Entwicklung zur Verfügung. Dieser einzigartige Supercomputer mit 20.736 B200 GPUs wird mit dem neuen NVIDIA GB200 NVL72 gebaut, einem System mit NVLink der fünften Generation, das mit 10.368 NVIDIA Grace CPUs verbunden ist. Das System skaliert unter Verwendung von EFA-Netzwerken der vierten Generation und bietet einen Netzwerkdurchsatz von bis zu 800 Gbit/s pro Superchip mit niedriger Latenz und hoher Bandbreite. Damit kann eine gewaltige KI-Leistung von 414 Exaflops verarbeitet werden - eine 6-fache Leistungssteigerung gegenüber früheren Plänen, Ceiba auf der Hopper-Architektur aufzubauen. Die Forschungs- und Entwicklungsteams von NVIDIA werden Ceiba nutzen, um KI für LLMs, Grafik (Bild-/Video-/3D-Generierung) und Simulation, digitale Biologie, Robotik, selbstfahrende Autos, NVIDIA Earth-2-Klimavorhersage und vieles mehr voranzutreiben, um NVIDIA bei zukünftigen generativen KI-Innovationen zu unterstützen.

Die Zusammenarbeit von AWS und NVIDIA beschleunigt die Entwicklung von generativen KI-Anwendungen und fördert Anwendungsfälle im Gesundheitswesen und in den Biowissenschaften

AWS und NVIDIA haben sich zusammengetan, um die computergestützte Arzneimittelforschung mit neuen NVIDIA BioNeMo™ FMs für die generative Chemie, die Vorhersage von Proteinstrukturen und das Verständnis der Interaktion von Arzneimittelmolekülen mit Targets zu erweitern. Diese neuen Modelle werden in Kürze auf AWS HealthOmics verfügbar sein, einem speziell entwickelten Service, der Unternehmen im Gesundheitswesen und in den Biowissenschaften beim Speichern, Abfragen und Analysieren von Genom-, Transkriptom- und anderen Omics-Daten unterstützt.

Die Teams von AWS HealthOmics und NVIDIA Healthcare arbeiten außerdem gemeinsam an der Einführung von generativen KI-Microservices, um die Arzneimittelforschung, die Medizintechnik und die digitale Gesundheit voranzubringen. Dabei wird ein neuer Katalog von GPU-beschleunigten Cloud-Endpunkten für Biologie-, Chemie-, Bildgebungs- und Gesundheitsdaten bereitgestellt, damit Unternehmen im Gesundheitswesen die neuesten Fortschritte der generativen KI auf AWS nutzen können.

Nvidia unter Druck: Warum die Zukunft der KI auf Spezialisierung statt Größe setzt

Nvidia unter Druck: Warum die Zukunft der KI auf Spezialisierung statt Größe setzt

& Profi-Tools von

& Profi-Tools von