NVIDIA kündigt „Blackwell“ an – eine neue Generation von KI-Grafikprozessoren

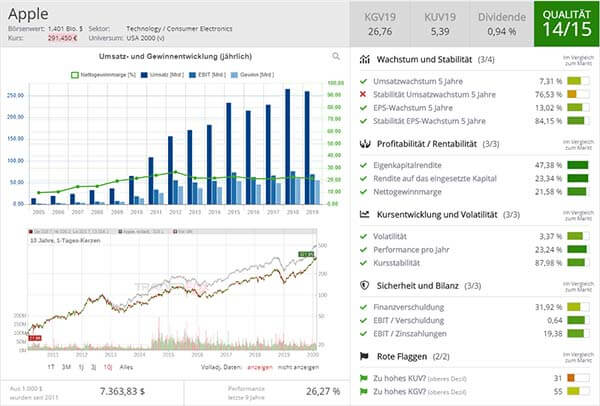

Aufklärung über Eigenpositionen: Diese Aktien aus dem Artikel halten TraderFox-Redakteure aktuell

Am Montag, den 18.03., hat der Chipkonzern NVIDIA im Rahmen seiner Entwicklerkonferenz in San Jose eine neue Generation von Chips für Künstliche Intelligenz und Software zur Ausführung von KI-Modellen angekündigt. Unternehmen und Softwarekonzerne streben weiterhin danach, die aktuelle Generation des Hopper wie den "H100" und ähnliche Chips zu erwerben. Auf der Konferenz äußerte sich NVIDIA-CEO Jensen Huang dahingehend, dass "Hopper" zwar fantastisch sei, aber man größere GPUs benötige.

Deutliche Steigerung der KI-Leistung gegenüber dem H100

Die neueste Generation von KI-Grafikprozessoren wird unter dem Namen "Blackwell" eingeführt. Der erste Chip, der "GB200", soll noch in diesem Jahr auf den Markt kommen. Mit Blackwell-basierten Prozessoren wie dem GB200 wird eine enorme Leistungssteigerung für KI-Unternehmen erwartet – mit 20 "Petaflops" an KI-Leistung im Vergleich zu 4 "Petaflops" beim H100. Das ermögliche es den Unternehmen, größere und komplexere Modelle zu trainieren, so der US-Konzern. Der Chip enthält laut NVIDIA eine sogenannte "Transformator-Engine", die speziell für transformatorbasierte KI entwickelt wurde – eine der Kerntechnologien, auf denen ChatGPT basiert.

Die Blackwell-GPU ist groß und wird auch als vollständiger Server mit der Bezeichnung GB200 NVLink 2 erhältlich sein. Dabei werden 72 Blackwell-GPUs und andere NVIDIA-Komponenten kombiniert, um KI-Modelle zu trainieren. Technologiegiganten wie Amazon, Google, Microsoft und Oracle werden Zugang zum GB200 über Cloud-Dienste anbieten. Laut NVIDIA plant Amazon Web Services den Aufbau eines Server-Clusters mit 20.000 GB200-Chips.

Zu den Kosten für den neuen GB200 oder die Systeme wurden keine Angaben gemacht. Der Hopper-basierte H100 kostet zwischen 25.000 und 40.000 USD pro Chip, wobei ganze Systeme laut Analystenschätzungen bis zu 200.000 USD kosten könnten.

NIM soll die Verwendung älterer NVIDIA-GPUs erleichtern

Darüber hinaus hat der Konzern "NIM" vorgestellt, die den Einsatz von KI vereinfachen soll. NIM steht für NVIDIA Inference Microservice und soll die Verwendung älterer NVIDIA-GPUs für Inferenzen oder den Prozess der Ausführung von KI-Software erleichtern. Das soll es Unternehmen, die Hunderte Millionen NVIDIA-GPUs besitzen, ermöglichen, diese weiterhin zu nutzen. Die Strategie besteht darin, Kunden, die NVIDIA-basierte Server kaufen, dazu zu bringen, sich für NVIDIA Enterprise anzumelden, das 4.500 USD pro GPU und Jahr für eine Lizenz kostet.

Laut CNBC aktualisiert das Unternehmen seine GPU-Architektur alle zwei Jahre, was zu signifikanten Leistungssteigerungen führt. Viele der KI-Modelle des vergangenen Jahres seien auf der Hopper-Architektur des Unternehmens trainiert worden, so die Nachrichtenseite.

Konzern wird immer mehr zu einem Plattform-Anbieter

NVIDIA-Führungskräfte haben betont, dass das Unternehmen immer mehr zu einem Plattform-Anbieter werde, auf dem andere Unternehmen Software aufbauen können. Auch Blackwell werde nicht als Chip betrachtet, sondern sei der Name einer Plattform, wie Huang ausführte. Das kommerzielle Produkt sei die GPU gewesen, während die Software den Anwendern dabei geholfen hat, die GPU auf verschiedene Weise zu nutzen, so NVIDIAs Enterprise VP Manuvir Das. Natürlich werde das Unternehmen dies auch weiterhin tun, aber die wesentliche Veränderung bestehe darin, dass NVIDIA mittlerweile ein echtes kommerzielles Softwaregeschäft betreibe, fuhr er fort.

& Profi-Tools von

& Profi-Tools von