Neue KI-Ära für Content Creator und Filmemacher – Meta mit Forschungsergebnissen zu „Movie Gen“

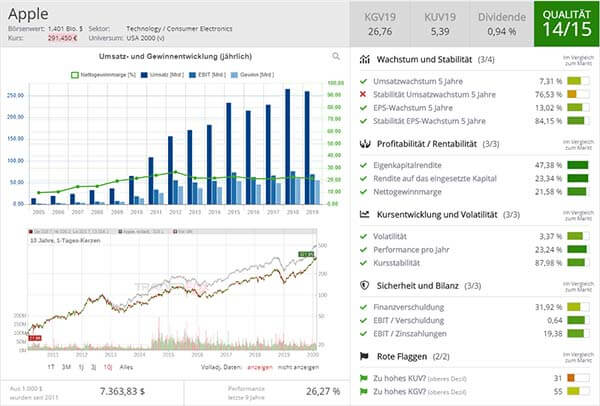

Aufklärung über Eigenpositionen: Diese Aktien aus dem Artikel halten TraderFox-Redakteure aktuell

Der Facebook-Mutterkonzern Meta hat am vergangenen Freitag, den 4. Oktober, seine Forschungsergebnisse zu einer neuen Gruppe von Modellen vorgestellt. Die Forschung zu "Movie Gen" umfasst Funktionen zur Videogenerierung, personalisierten Videogenerierung, präzisen Videobearbeitung und Audiogenerierung. Laut Meta übertrifft "Movie Gen" in diesen Bereichen vergleichbare Modelle.

Meta hofft, dass in Zukunft jeder "Movie Gen" nutzen kann, um seine künstlerischen Visionen zu verwirklichen und hochauflösende Videos und Audios zu erstellen. Die Forschung hat laut dem Unternehmen ein enormes Potenzial für zukünftige Anwendungen, wenngleich Meta einräumt, dass die aktuellen Modelle noch "limitiert" seien. So könnte die Inferenzzeit weiter verkürzt werden und die Qualität der Modelle durch eine weitere Skalierung verbessert werden. Während die Modelle weiterentwickelt werden und eine mögliche Veröffentlichung in Aussicht stehen könnte, plant Meta eine enge Zusammenarbeit mit Filmemachern und Creator, um deren Feedback zu integrieren. Eine mögliche Anwendung wäre etwa die Animation eines Videos über "Einen Tag im Leben", das als Reel geteilt und mithilfe von Texteingaben erstellt werden könnte. Ebenso könnte ein Nutzer eine personalisierte, animierte Geburtstagsnachricht für einen Freund erstellen und diese über WhatsApp versenden. Die Möglichkeiten seien "unendlich", so Meta in einem Blogpost.

State-of-the-art Modell im Bereich Videogenerierung

Auf Basis einer Texteingabe (Prompt) kann ein gemeinsames Modell genutzt werden, das sowohl für die Umwandlung von Text-zu-Bild als auch für Text-zu-Video optimiert ist. Das Transformatormodell mit 30 Mrd. Parametern kann Videos mit einer Länge von bis zu 16 Sekunden und einer Bildrate von 16 Bildern pro Sekunde erzeugen. Die Modelle sind laut den Forschungsergebnissen in der Lage, Bewegungen von Objekten, Interaktionen zwischen Subjekt und Objekt sowie Kamerabewegungen zu verstehen. Dadurch sollen plausible Bewegungen für eine Vielzahl von Konzepten erlernt werden können, was die Modelle laut Meta zu den "innovativsten" (state-of-the-art models) ihrer Art macht.

Erweiterung des Basismodells zur Erstellung personalisierter Videos

Meta hat das Basismodell erweitert, um personalisierte Videos zu generieren. Dabei kann ein Bild einer Person mit einer Texteingabe kombiniert werden, um ein Video zu erstellen, das sowohl die Person als auch visuelle Details des Prompts enthält. Laut Meta liefert dieses Modell herausragende Ergebnisse, bei denen die Identität und Bewegungen der Personen bewahrt werden.

Präzise Videobearbeitung: Kombination von Texteingaben und fortschrittlicher Bildbearbeitung

In dieser Variante werden sowohl ein Video als auch ein Texteingabe-Prompt als Input verwendet, um präzise Bearbeitungen durchzuführen. Die Videogenerierung wird mit fortschrittlicher Bildbearbeitung kombiniert, um lokale Änderungen wie das Hinzufügen, Entfernen oder Ersetzen von Elementen sowie globale Änderungen wie Hintergrund- oder Stiländerungen vorzunehmen. Im Gegensatz zu herkömmlichen Tools, die spezielle Fähigkeiten erfordern, oder generativen Anwendungen, denen es an Präzision mangelt, bewahrt "Movie Gen" den ursprünglichen Inhalt und bearbeitet nur die relevanten Pixel.

Hochwertige, synchronisierte Audiospuren und unbegrenzte Audioerweiterung für Videos

Meta hat zudem ein Audiogenerierungsmodell mit 13 Mrd. Parametern entwickelt. Dieses Modell kann ein Video und optionale Texteingaben verarbeiten und eine qualitativ hochwertige und originalgetreue Audiospur von bis zu 45 Sekunden Länge generieren – einschließlich Umgebungsgeräuschen, Soundeffekten und instrumentaler Hintergrundmusik, alles synchron zum Video. Darüber hinaus wurde eine Technik zur Audioerweiterung eingeführt, die kohärentes Audio für Videos beliebiger Länge erzeugen kann.

& Profi-Tools von

& Profi-Tools von